Artículo escrito conjuntamente por Carmine Clementelli y Jason Clark

En los últimos tiempos, el auge de la inteligencia artificial (IA) ha revolucionado la forma en que cada vez más usuarios corporativos interactúan con su trabajo diario. Las aplicaciones SaaS basadas en IA generativa, como ChatGPT, han ofrecido innumerables oportunidades a las organizaciones y a sus empleados para mejorar la productividad del negocio, facilitar numerosas tareas, mejorar los servicios y ayudar a agilizar las operaciones. Los equipos humanos y los individuos pueden aprovechar cómodamente ChatGPT para generar contenidos, traducir textos, procesar grandes cantidades de datos, elaborar rápidamente planes financieros, depurar y escribir código, entre otros usos.

Sin embargo, aunque las aplicaciones de IA tienen el potencial de mejorar nuestro trabajo, también pueden exponer significativamente los datos sensibles a vehículos externos de pérdida de datos y poner aún más a las organizaciones en riesgo de filtraciones de datos e incumplimiento.Como mi colega Yihua Liao, responsable de Netskope AI Labs, señaló recientemente, “al reconocer y abordar estos desafíos, los departamentos de seguridad pueden garantizar que la IA se utilice de manera responsable y efectiva en la lucha contra las amenazas cibernéticas.”

He aquí algunos ejemplos concretos de cómo los datos sensibles pueden quedar expuestos a ChatGPT y otras aplicaciones de IA basadas en la nube:

- El texto que contiene datos personales se puede copiar y pegar en el chatbot para generar ideas de correo electrónico, respuestas a las consultas de los clientes, cartas personalizadas, comprobar el análisis de opiniones

- La información sobre salud puede introducirse en el chatbot para elaborar planes de tratamiento individualizados, e incluso imágenes médicas como tomografías computarizadas y resonancias magnéticas pueden procesarse y mejorarse gracias a la IA

- Los desarrolladores de software pueden cargar código fuente propio para depurar, completar código, mejorar la legibilidad y el rendimiento

- Los archivos que contengan secretos de empresa, como borradores de informes de resultados, documentos de fusiones y adquisiciones (M&A), anuncios previos a la publicación y otros datos confidenciales, pueden cargarse para su revisión gramatical y de redacción

- La información financiera como transacciones corporativas, ingresos operativos no revelados, números de tarjetas de crédito, calificaciones crediticias de clientes, extractos e historiales de pago pueden utilizar ChatGPT para la planificación financiera, el procesamiento de documentos, la incorporación de clientes, la síntesis de datos, el cumplimiento normativo, la detección de fraudes, etc.

Las organizaciones deben tomar serias contramedidas para salvaguardar la confidencialidad y la seguridad de sus datos sensibles en nuestro mundo moderno basado en la nube, supervisando el uso y abuso de aplicaciones e instancias SaaS de riesgo, limitando la exposición de información sensible a través de ellas y protegiendo los documentos confidenciales de pérdidas y robos accidentales.

Cómo Netskope ayuda a prevenir los riesgos cibernéticos de ChatGPT

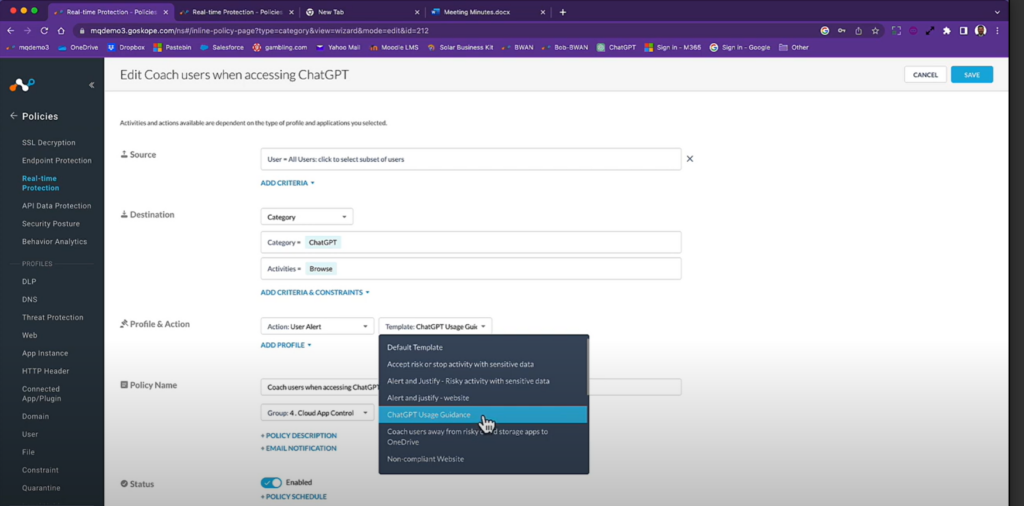

Todo empieza con la visibilidad. Los departamentos de seguridad deben aprovechar las herramientas automatizadas que supervisan continuamente a qué aplicaciones (como ChatGPT) intentan acceder los usuarios corporativos, cómo, cuándo, desde dónde, con qué frecuencia, etc. Es esencial comprender los diferentes niveles de riesgo que cada aplicación supone para la organización y tener la capacidad de definir de forma granular políticas de control de acceso en tiempo real basadas en categorizaciones y condiciones de seguridad que pueden cambiar con el tiempo.

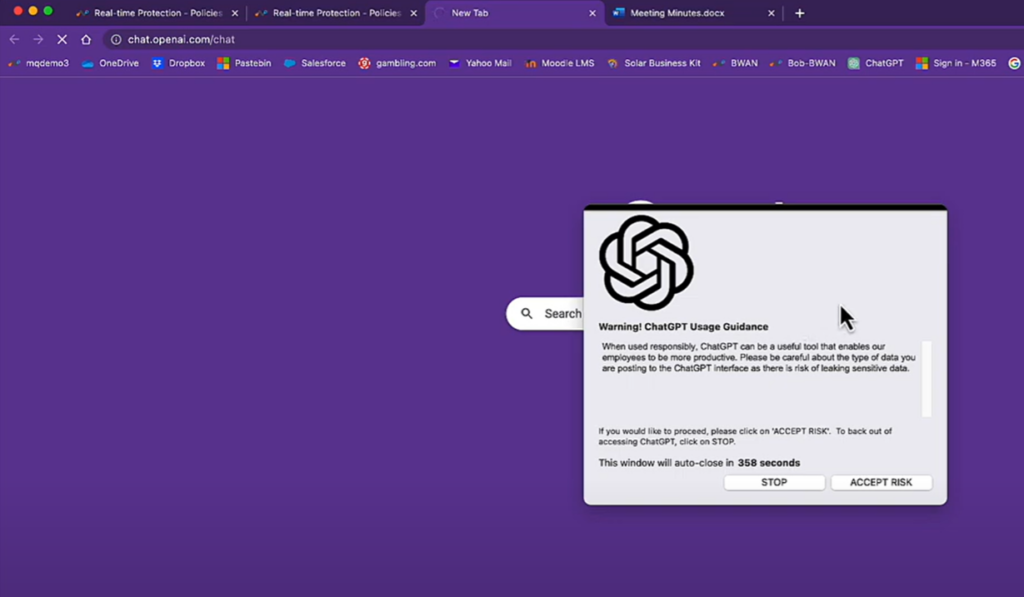

Mientras que las aplicaciones que son más explícitamente maliciosas deben ser bloqueadas, cuando se trata de control de acceso, muchas veces la responsabilidad del uso de aplicaciones como ChatGPT debe ser dada a los usuarios, tolerando y no necesariamente deteniendo actividades que pueden tener sentido para un subconjunto de grupos de negocio o para la mayoría de ellos. Al mismo tiempo, los departamentos de seguridad tienen la responsabilidad de concienciar a los empleados sobre las aplicaciones y actividades que se consideran de riesgo. Esto puede lograrse principalmente mediante alertas en tiempo real y procesos de asesoramiento automatizados, implicando al usuario en las decisiones de acceso tras reconocer el riesgo.

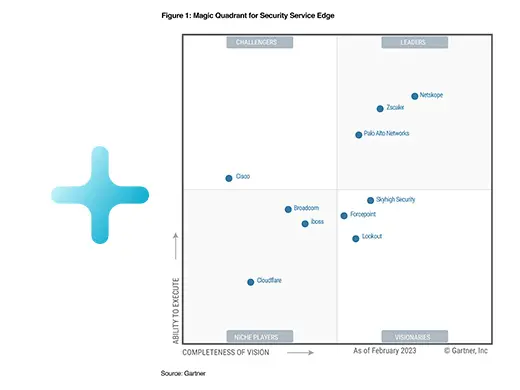

Netskope es líder del mercado en seguridad en la nube y protección de datos, con más de una década de experiencia, ofreciendo la más amplia visibilidad y el más preciso control sobre miles de nuevas aplicaciones SaaS como ChatGPT. Netskope proporciona opciones de seguridad flexibles para controlar el acceso a aplicaciones SaaS basadas en IA generativa como ChatGPT y para proteger automáticamente los datos sensibles. Ejemplos de políticas de control de acceso incluyen procesos e asesoramiento en tiempo real que se activan cada vez que los usuarios abren ChatGPT, como ventanas emergentes de advertencia personalizables que ofrecen orientación sobre el uso responsable de la aplicación, el riesgo potencial asociado y una solicitud de reconocimiento o justificación.

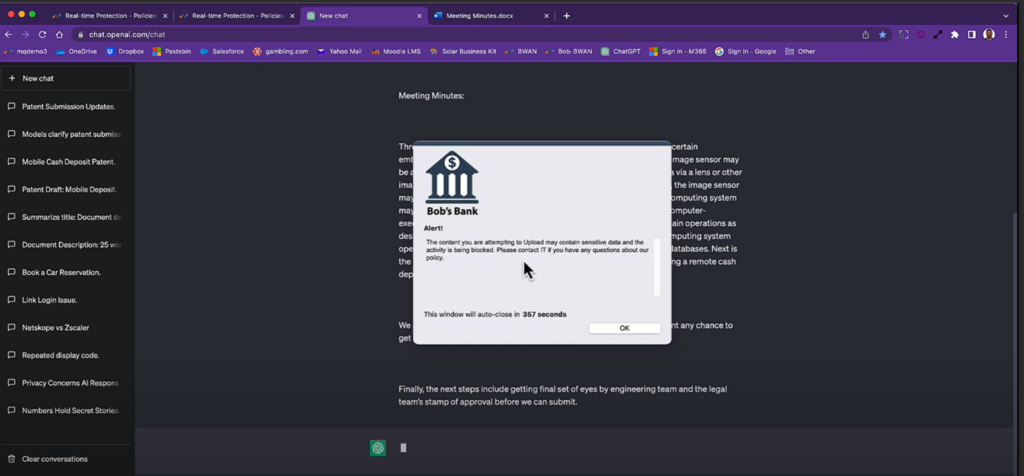

Los usuarios cometen errores y pueden poner en peligro datos sensibles por negligencia. Aunque se puede conceder el acceso a ChatGPT, es primordial limitar la carga y publicación de datos muy sensibles a través de ChatGPT y a través de otros vectores de exposición de datos potencialmente arriesgados en la nube. Esto sólo puede lograrse mediante técnicas modernas de prevención de pérdida/fuga de datos (DLP), y las capacidades DLP sumamente avanzadas de Netskope son capaces de identificar automáticamente los flujos de datos sensibles y categorizar las publicaciones sensibles con el máximo nivel de precisión.

La precisión garantiza que el sistema solo supervisa e impide la carga de datos confidenciales (incluidos archivos y texto pegado en el portapapeles) a través de aplicaciones basadas en IA generativa y no detiene consultas inofensivas y tareas seguras a través del chatbot. La madurez cuenta y, de nuevo, Netskope ofrece más de una década de experiencia y el más alto grado de eficacia en protección de datos en prevención de pérdida/fuga de datos (DLP) en la nube. Con la DLP avanzada de Netskope, impulsada por modelos de aprendizaje automático e inteligencia artificial, miles de tipos de archivos, datos personales, propiedad intelectual, registros financieros y otros datos sensibles se identifican con confianza y se protegen automáticamente de la exposición no deseada y no conforme a las normativas.

Además de detener de forma selectiva las cargas y publicaciones de información confidencial en ChatGPT, se pueden automatizar mensajes de asesoramiento visual en tiempo real para proporcionar orientación sobre las infracciones de publicación de datos, informar al usuario sobre las políticas de seguridad corporativas y permitir mitigar comportamientos de riesgo repetidos a lo largo del tiempo, quitando la carga a los equipos de respuesta de seguridad.

Para obtener más información, vea nuestro vídeo de demostración sobre cómo habilitar de forma segura ChatGPT o visite:

- https://www.netskope.com/netskope-ai-labs

- https://www.netskope.com/products/casb

- https://www.netskope.com/products/data-loss-prevention

Additionally, if you’re interested in hearing more about generative AI and data security, please register for our LinkedIn Live event ChatGPT: Fortifying Data Security in the AI App-ocalypse, featuring Krishna Narayanaswamy, Naveen Palavalli, and Neil Thacker, on Thursday, June 22 at 9:30am PT.